GPT-5.3-Codex-Spark登場!Codexが速さ重視になった背景

AIがコードを書く時代は、すでに始まっています。次に変わるのは「賢さ」ではなく「待ち時間」です。OpenAIが発表したGPT-5.3-Codex-Sparkは、ほぼ即時に応答することを重視したモデルです。何が起きたのかを、ポイントを押さえて整理します。

ARCHETYP Staffingでは現在クリエイターを募集しています。

エンジニア、デザイナー、ディレクター以外に、生成AI人材など幅広い職種を募集していますのでぜひチェックしてみてください!

GPT-5.3-Codex-Sparkは何が新しいのか──“待たない”という価値

GPT-5.3-Codex-Sparkは、GPT-5.3-Codexの小型版として開発された、リアルタイムでのコーディング作業に特化したモデルです。特徴ははっきりしていて、「できることを増やす」より「待たせない」ことを優先しています。

OpenAIは、このモデルを“リアルタイムコーディング向けに設計された最初のモデル”と位置づけています。コードの一部を直し、少し形を変え、また直す。そうした作業をテンポよく繰り返せるように、応答速度を最優先にしています。発表では毎秒1,000トークン以上を生成できるとされており、トークンとはAIが文章やコードを出力する単位のことです。

もう一つの特徴は、動作が軽いことです。Codex-Sparkは、必要最小限の修正を行うことを基本とし、こちらから頼まない限りテストも自動では実行しません。賢く先回りして全部やるのではなく、ユーザーの操作に素早く返すことを優先した設計です。

コンテキストウィンドウは128kで、長めのコードや資料も一度に扱えます。現在はテキスト専用で、ChatGPT Proユーザー向けに研究プレビューとして提供されています。通常の利用制限とは別のレート制限が用意されている点からも、まだ拡大途中の段階であることが分かります。さらに、SWE-Bench ProやTerminal-Bench 2.0といった評価指標では、GPT-5.3-Codexと比べて短い時間でタスクを完了しつつ高い性能を示したと説明されています。つまりCodex-Sparkは、小さくした代わりに弱くなったモデルではなく、「速さを武器にする」役割を与えられたモデルです。

そして、この速さはモデルだけで生まれたものではありません。裏側の仕組みそのものが作り直されています。

なぜここまで速いのか──AIの裏側で起きた「待ち時間」の削減

OpenAIが発表で強調しているのは、リアルタイム体験を作るうえで重要なのはモデルの処理速度だけではない、という点です。リクエストを送ってから返事が表示されるまでの流れ全体に「ムダ」がある限り、体感としては速くなりません。

そこでOpenAIは、応答が返ってくるまでの通信や処理の流れを見直し、数字としても改善を示しました。クライアントとサーバー間の往復にかかる負荷は80%削減され、1トークンあたりの処理負荷は30%削減、最初の文字が表示されるまでの時間は50%短縮されたとされています。最初の表示が早いほど、体感の待ち時間は一気に減ります。

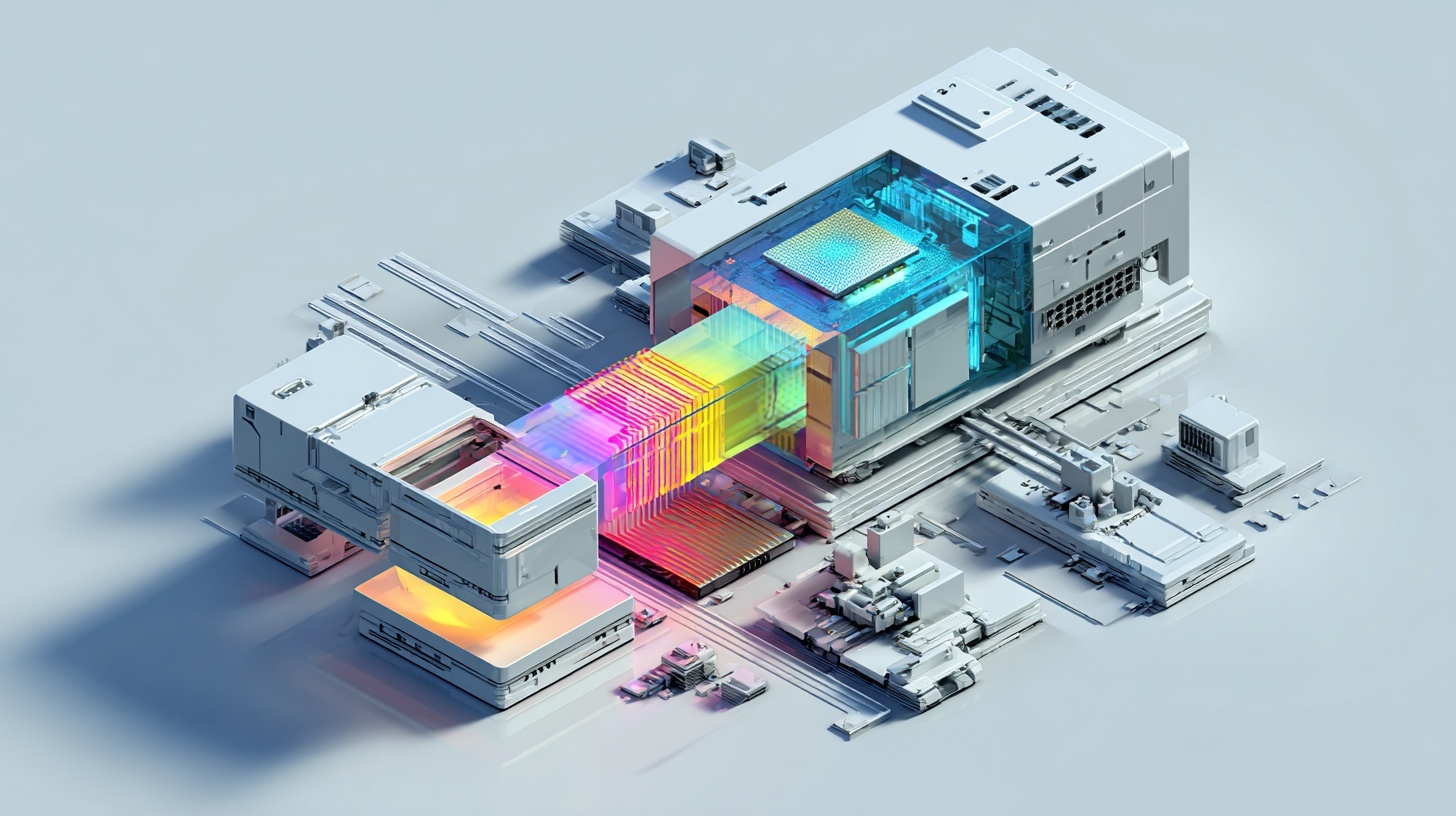

また、Codex-SparkではWebSocketという通信方式が標準で有効化されています。これは常時接続を保つ仕組みで、細かなやり取りを何度も繰り返す場面で効率が上がります。加えて、Codex-SparkはCerebrasのWafer Scale Engine 3という推論専用のハードウェア上で動作します。OpenAIはこれを「低遅延の提供ルート」として、既存の本番サービング基盤に組み込んだと説明しています。

ただし、GPUが不要になったわけではありません。GPUは引き続きトレーニングと推論の基盤として重要で、Cerebrasは「とにかく待たせない」用途を補う存在として説明されています。つまり、速さを支えているのはモデル単体の話ではなく、通信、基盤、ハードウェアをまとめて整えた結果です。そして、この設計は単発の実験ではなく、Codexが今後どんな方向に進むかにも直結しています。

Codexは二つの使い方に分かれる──「任せるAI」と「一緒にやるAI」

OpenAIは、Codexを二つの補完的なモードで捉えています。ひとつは、長時間にわたって自律的に作業を続けるモードです。数時間、数日、場合によっては数週間にわたって介入なしで動き続けられることが、最新モデルの強みとして述べられています。

もうひとつが、Codex-Sparkが担うリアルタイム協働のモードです。こちらは長時間動くことが目的ではなく、その場で修正し、形を整え、結果をすぐ見て次の一手を決めるための設計です。長期型と即時型はどちらが優れているという話ではなく、用途が違うという整理になっています。

発表では、今後この二つが混ざっていく構想も示されています。対話のテンポを保ったまま、裏側では長い作業を別のモデルに任せたり、複数のモデルに並列で処理させたりする方向性です。ただし、これはあくまで方針として語られており、具体的な実装時期は明示されていません。

またCodex-Sparkは、安全性についても主要モデルと同様のトレーニングが行われ、標準的な評価プロセスを通したうえで、サイバーセキュリティや生物分野において高リスク水準に達する可能性はないと判断されたと説明されています。速さだけを追ったモデルではなく、提供の枠組みも維持されているということです。

Codex-Sparkは、単なる新モデルではありません。「任せる」と「一緒にやる」を分けて設計することで、AIとの距離をもっと自然なものにしようとする一歩です。

まとめ

いかがだったでしょうか?

GPT-5.3-Codex-Sparkは、モデルの賢さではなく「待ち時間」を縮めることに焦点を当てた発表でした。Cerebrasとの連携や通信の見直しにより、リアルタイムでの共同作業が現実的な形で提示されています。長時間任せる使い方と、その場で一緒に進める使い方が整理されたことで、Codexの方向性はより分かりやすくなりました。AIは静かに、使われ方そのものを変え始めています。